Inteligencia artificial: ¿progreso o retroceso?

No avanzaremos si el futuro digital perpetúa los errores del pasado. Si por cada euro que se invierte en nuevos algoritmos se invirtiera otro en regulación, habría más razones para ser optimistas sobre el porvenir.

14 de junio 2019

Uno de los mayores riesgos de la inteligencia artificial es que perpetúe los errores y prejuicios del pasado, camuflándolos bajo un barniz de objetividad. Los sistemas de inteligencia artificial se entrenan a partir de datos que reflejan las decisiones que hemos tomado en el pasado. Cuando la inteligencia artificial de reclutamiento de Amazon discriminó a las mujeres, no fue porque los hombres fueran mejores candidatos para los trabajos disponibles. A través de una base de datos que contenía un historial de contratación, Amazon le enseñó a su sistema que la empresa ha preferido contratar a hombres durante los últimos 10 años. En otras palabras, el algoritmo perpetuó un prejuicio sexista que estaba grabado en los datos del pasado.

PredPol, el sistema de inteligencia artificial utilizado por la policía en Estados Unidos, tiene problemas similares. En vez de predecir crímenes, que es lo que se supone que tendría que hacer, reproduce hábitos policiacos. Ahí donde patrulla la policía, encuentran crímenes que dan a procesar al algoritmo, que a su vez recomienda que se continúe patrullando las mismas zonas. Las áreas en donde hay mayor presencia policial, y en consecuencia más arrestos, son zonas pobladas por minorías. El resultado es que estas minorías están siendo indirectamente discriminadas.

Una de las grandes falacias asociadas al optimismo sobre el big data es creer que cuantos más datos tengamos, mejor. Habría que revisitar las palabras del poeta T. S. Eliot, que escribió: “¿Dónde está la sabiduría que hemos perdido con el conocimiento? ¿Dónde está el conocimiento que hemos perdido con la información?”. Recolectar más datos no garantiza que sean precisos, ni que estén actualizados y sean relevantes para cumplir nuestros objetivos, ni mucho menos que seamos capaces de poner esos datos al servicio de la justicia, la democracia, la igualdad y el bienestar.

De momento, el ‘big data’ parece que está incrementando los sesgos y solidificando el ‘statu quo’

Se dice que el big data va a revolucionar la ciencia. De momento, la inteligencia artificial manifiesta más estupidez que inteligencia. Entre otras muchas limitaciones, la inteligencia artificial solo es capaz de rastrear correlaciones, lo que no necesariamente nos lleva a entender mejor las relaciones de causa y efecto que gobiernan la realidad. El que los algoritmos detecten correlaciones es otro elemento que los hace resistentes a reconocer o impulsar cambios. Dos elementos que han estado correlacionados en el pasado (por ejemplo, ser mujer y tener un trabajo mal pagado) no tienen por qué estar correlacionados en el futuro, pero si nuestros algoritmos nos llevan a actuar como si las correlaciones fueran una verdad objetiva e inmutable, es más probable que la inteligencia artificial no genere predicciones neutrales, sino profecías autocumplidas.

También se cree que el big data tiene el potencial de eliminar los sesgos en las decisiones humanas; de momento, como hemos visto, parece que está incrementando los sesgos y solidificando el statu quo.

Un factor que posibilita los cambios sociales es la capacidad humana de olvidar aquello que nos ata al pasado. En su magnífico libro Delete, Viktor Mayer-Schönberger argumenta que tener una memoria perfecta, ya sea como individuos o como sociedad, puede ser un obstáculo para cambiar a mejor. Nuestra memoria biológica es un sistema fantástico de filtración y organización de la información: recordamos lo importante, olvidamos lo insignificante, reconstruimos el pasado constantemente a la luz del presente, y le damos diferentes valores a diferentes memorias. La memoria digital lo recuerda todo sin reinterpretarlo ni valorarlo; es la antítesis de nuestra memoria biológica, forjada a través de milenios de evolución. Las consecuencias de no poder olvidar pueden ser desastrosas.

Si no somos capaces de olvidar los errores que alguien ha cometido (y todos cometemos errores), o por lo menos de tenerlos menos presentes, es difícil que podamos darle una segunda oportunidad. Es verdad que no hay que olvidar las lecciones del pasado, pero aprender de la historia no es lo mismo que mantener un registro de cada infracción que cada persona comete. Lo segundo lleva a tener una sociedad implacable, rígida, que eterniza las injusticias del pasado. Por eso el derecho al olvido es tan importante, y un acierto del Reglamento General de Protección de Datos (RGPD).

Aprender de la historia no es lo mismo que mantener un registro de las infracciones que cada persona comete

Otro factor necesario para posibilitar cambios es la capacidad humana de tener consciencia social. Los seres humanos somos seres sintientes y agentes morales. Como seres sintientes, sabemos lo que es el sufrimiento y el bienestar en nuestra piel, y somos capaces de sentir empatía con otros que sufren. Como agentes morales, entendemos las consecuencias que nuestras acciones pueden tener en otros. Comprendemos que en ocasiones hay que hacer una excepción a la regla —cuando la regla no abarca todos los casos posibles o cuando una persona merece una segunda oportunidad—. Somos capaces de reflexionar sobre nuestros valores y actuar en consecuencia.

Los algoritmos no son ni seres sintientes ni agentes morales. Son incapaces de sentir dolor, placer, remordimiento o empatía. Son incapaces de entender las consecuencias de sus acciones —solo los seres que pueden experimentar dolor y placer pueden entender lo que significa infligir dolor o causar placer. Los algoritmos no tienen valores ni son capaces de hacer una excepción a la regla. No toman en cuenta que en muchas ocasiones las transgresiones humanas son producto de la injusticia (la falta de oportunidades que lleva al crimen, por ejemplo). No pueden reflexionar sobre el tipo de vida que quieren llevar, o el tipo de sociedad en la que quieren vivir, y actuar en consecuencia. Un coche autónomo no puede decidir andar menos kilómetros para no contaminar. Un robot de guerra no puede convertirse en pacifista después de reflexionar sobre las consecuencias de los conflictos armados. Los algoritmos no pueden tener consciencia social.

Es una trampa creer que la tecnología puede resolver por sí misma problemas que son fundamentalmente éticos y políticos. El reto más importante que tenemos por delante es uno de gobernanza. Si por cada euro que se invierte en inteligencia artificial se invirtiera otro euro en regulación y gobernanza, tendríamos más razones para ser optimistas sobre el futuro digital. Ahora mismo, los incentivos premian el uso de la inteligencia artificial para tomar decisiones. Si las instituciones usan algoritmos para tomar decisiones, se ahorran dinero al tener que pagar menos sueldos, pueden defender sus decisiones como si fueran objetivas, y si algo sale mal, pueden culpar al algoritmo. Cuando quienes más arriesgan (los ciudadanos a merced de los algoritmos) son diferentes que quienes más se benefician de ese riesgo (las empresas, los Gobiernos), se crean asimetrías de poder. El papel de los reguladores es asegurarse de que los incentivos de las instituciones estén alineados con los intereses de la población. Si la inteligencia artificial daña a los ciudadanos, tiene que haber consecuencias proporcionales para las personas responsables de ese algoritmo.

A pesar de su complejidad, los algoritmos no son más que herramientas, y los agentes morales somos totalmente responsables de las herramientas que creamos y utilizamos. Si dejamos que los algoritmos decidan basándose en datos del pasado, seremos responsables de repetir nuestros errores, de frenar el progreso social a tal punto que empecemos a retroceder.

Carissa Véliz es investigadora en el Uehiro Centre for Practical Ethics y el Wellcome Centre for Ethics and Humanities en la Universidad de Oxford.

Te puede interesar

Publicaciones del COMECSO

Roberto Holguín Carrillo - Ene 08, 2025Este espacio reúne la gran mayoría de la producción editorial de nuestra asociación. A lo largo de casi cinco décadas,…

COMECSO felicita al Dr. Gustavo Adolfo Urbina Cortés

comecso - Mar 14, 2025

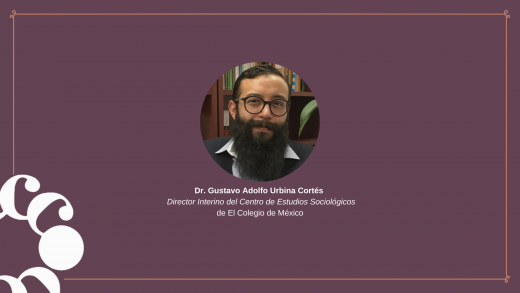

¿Qué es belleza y por qué importa? Interpelaciones en y desde el género y el cuerpo

Laura Gutiérrez - Mar 14, 2025Universidad Nacional Autónoma de México, Centro de Investigaciones Multidisciplinarias sobre Chiapas y la Frontera Sur, Educación Continua Curso ¿Qué es…

Inteligencia artificial y su impacto en las políticas públicas y la economía Global

Laura Gutiérrez - Mar 14, 2025Inteligencia artificial y su impacto en las políticas públicas y la economía Global Número 137 | Año 38 | Enero-Junio…